揭开网络安全秘密:轻松识破伪装爬虫

2024-08-15 23:04

引言

在互联网的广阔领域中,每天都有数以亿计的网页和数据通过看不见的渠道流动。然而,随着数据的重要性日益增加,网络安全已成为每个网站运营者必须面对的关键挑战。我们的网站就像一个虚拟的堡垒,既需要对真实用户开放,也要设法防御那些隐藏在数据流中的“敌人”。这些“敌人”可能是无害的爬虫,也可能是恶意的入侵者,他们往往伪装成普通访客,企图窃取信息、破坏系统或消耗资源。因此,当我们的网站遭遇入侵时,如何通过IP精准区分真实用户和爬虫,成为网站防护的重中之重。

爬虫:隐秘的访客

在探讨如何区分真实用户和爬虫之前,我们首先需要了解这些爬虫是什么以及它们的行为特征。爬虫程序,或称为网络蜘蛛,是用于自动访问网站的工具。它们在互联网上无处不在,扮演着信息收集者的角色。这些爬虫有些是“友善”的访客,为我们的网站带来了流量和曝光;然而,另一些则是不怀好意的侵略者,可能对我们的网站造成极大的损害。

有益爬虫:互联网的搬运工

首先,让我们看看那些“友善”的爬虫,它们帮助我们的网站以更积极的方式被互联网所认识。这些爬虫包括搜索引擎爬虫、市场营销爬虫、监控爬虫、信息流爬虫、链接检查爬虫、工具类爬虫、速度测试爬虫和漏洞扫描爬虫等。它们各司其职,为网站管理者提供了大量有价值的数据。

- 搜索引擎爬虫:这些爬虫是搜索引擎的基础。像Googlebot、Bingbot这样的爬虫会定期访问你的网站,收集并索引你的网站内容,使其能够在搜索引擎结果页面中显示。搜索引擎爬虫的访问对于提高网站的可见性至关重要。

- 市场营销爬虫:这些爬虫被企业广泛用于市场调研,它们会自动抓取竞争对手的网站数据,如产品价格、促销活动、用户评论等,为企业的市场决策提供数据支持。

- 监控爬虫:网络监控工具利用这些爬虫实时监控网站的运行状态,包括页面加载速度、可用性、性能等。通过这些爬虫的帮助,网站管理员能够及时发现并修复潜在的问题。

- 信息流爬虫:这些爬虫从各类新闻网站、社交媒体平台抓取最新的内容,并将其整合到信息流中,让用户可以第一时间获取最新资讯。例如,RSS聚合器使用爬虫从订阅的网站抓取内容并推送给用户。

- 链接检查爬虫:这些爬虫扫描网站内的所有链接,查找并报告损坏的链接或404错误页面,帮助管理员维护网站的健康状态,提升用户体验。

- 工具类爬虫:这类爬虫通常用于页面性能测试、结构分析等任务。它们通过访问并分析页面,提供一系列优化建议,帮助管理员提升网站的性能。

- 漏洞扫描爬虫:这些爬虫用于发现网站的潜在安全漏洞,如SQL注入点、XSS攻击点等。通过及时修复这些漏洞,网站可以有效抵御黑客攻击,保障数据安全。

恶意爬虫:隐蔽的威胁

然而,并非所有的爬虫都是无害的。一些恶意爬虫会伪装成合法访客,进行数据盗窃、非法抓取、资源滥用等活动,对网站的安全性构成威胁。这些恶意爬虫包括抓取类爬虫、伪造爬虫、资源消耗爬虫和数据窃取爬虫。

- 抓取类爬虫:未经授权的大规模数据抓取爬虫会窃取网站内容,并将其复制到其他平台。这不仅侵犯了网站的版权,还可能导致SEO排名下降,严重影响网站的流量和声誉。

- 伪造爬虫:这些爬虫通过伪造User-Agent头,冒充合法的搜索引擎爬虫,如Googlebot、Bingbot等,目的是绕过防火墙和其他安全措施,进行恶意活动,如分布式拒绝服务(DDoS)攻击、数据盗取等。

- 资源消耗爬虫:这些爬虫通过频繁访问来消耗网站的服务器资源,增加服务器负载,导致网站性能下降,甚至使网站无法正常服务。对于小型网站而言,这种攻击尤其具有破坏性。

- 数据窃取爬虫:这些爬虫专门针对网站上的敏感信息进行抓取,如用户登录信息、支付数据、个人信息等。被窃取的数据可能被用于非法交易、身份盗用或其他恶意行为,给用户和网站带来巨大的安全隐患。

从服务器日志中检测爬虫

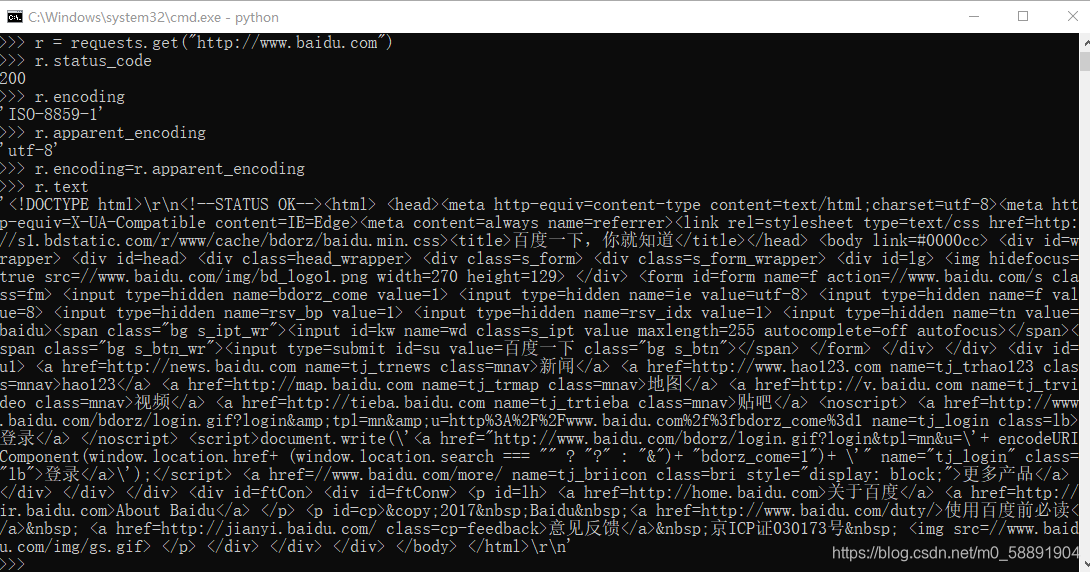

要从服务器日志中检测爬虫,你可以通过查看日志文件中的User-Agent字段和IP地址来识别爬虫的活动。常见的爬虫User-Agent如Googlebot、Bingbot等,可以帮助你判断请求是否来自合法爬虫,同时还可以通过反查IP地址和分析访问频率、访问模式等来确定是否存在伪造User-Agent或恶意爬虫。

在日志中,你会看到大量的IP,可以根据User-Agent初步判断哪些是爬虫,哪些是正常用户。例如:

- Mozilla/5.0 (compatible; SemrushBot/7~bl; +http://www.semrush.com/bot.html)

这是Semrush的爬虫。

- ` Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm) `

这是Bing的爬虫。

- Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/90.0.4430.97 Mobile Safari/537.36 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)

这是Google的爬虫。

然而,User-Agent可以轻易伪造,所以仅凭它无法准确判断访问者是否为爬虫。更为可靠的方式是结合IP进行检查。

例如,假设你在日志中看到如下记录:

66.249.71.19 - - [19/May/2021:06:25:52 +0800] "GET /history/16521060410/2019 HTTP/1.1" 302 257 "-" "Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/90.0.4430.97 Mobile Safari/537.36 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)"

这条记录显示IP为66.249.71.19,看起来像是Googlebot爬虫。为了确认其真实性,我们可以通过反查IP,查看其Hostname是否为crawl-66-249-71-19.googlebot.com,并通过ping命令确认Hostname的IP是否与日志中的IP匹配。如此便可确定该IP是否真正属于Google爬虫。如果IP存在疑问,还可以使用爬虫识别工具进一步查询。

借助第三方服务管理IP访问:提升防御效率

面对日益复杂的网络威胁,手动管理爬虫IP既耗时又低效。因此,越来越多的企业开始使用第三方服务来自动化这一过程。

IP反爬代理:阻挡恶意访问

IP反爬代理是一种专门设计用于防止恶意爬虫入侵的服务。推荐使用 Proxy4Free的住宅代理是业内广泛使用的反爬代理服务之一,它能够提供全球范围内的IP,并定期更新IP池。这些IP可以帮助企业有效阻挡恶意爬虫的访问,同时确保合法爬虫和真实用户的正常访问不受影响。

Proxy4Free等服务通过将恶意爬虫重定向到其他IP,减少了它们对服务器资源的消耗,从而提升网站的整体性能和安全性。对于需要处理大量数据的企业来说,这种服务尤其有价值,因为它能够自动化地管理大规模的IP,同时提供高效的安全防护。

自动化日志分析工具:实时监控与防护

除了IP反爬代理服务,自动化日志分析工具也是防止恶意爬虫入侵的有效手段。这些工具可以实时分析服务器日志,识别出异常的访问行为,并自动将可疑的IP加入黑名单,防止其进一步访问。

一些高级的日志分析工具还能够与企业现有的安全系统集成,实现全面的网络防护。例如,当一个IP的行为被识别为恶意时,系统可以自动触发安全警报,并采取相应的措施,如禁用该IP或通知管理员。

这些工具不仅提高了网站的安全性,还减少了管理员的工作量,使他们能够专注于其他更重要的任务。

结论

随着技术的不断进步,恶意爬虫的行为变得越来越隐蔽,给网站带来的威胁也越来越大。通过深入了解爬虫的行为模式,结合多种技术手段进行IP识别和管理,网站管理员可以有效地提升网站的防御能力,保障网站的安全性和正常运营。